大模型提示词技巧-基于场景的自检清单和缺失反问

大模型提示词技巧-基于场景的自检清单和缺失反问 概述 在复杂业务场景中,大模型需要处理信息不完整的情况。通过引入自检清单机制和缺失信息处理流程,可以显著提升模型输出的准确性和可靠性。本文档介绍如何设计和使用这些技巧。 提示词功能流程 本提示词方案的核心功能流程如下: 用户提问 ↓ [场景识别] 简单场景与复杂场景自动区分 ↓ ├─→ 简单场景 → [直接回答...

大模型提示词技巧-基于场景的自检清单和缺失反问 概述 在复杂业务场景中,大模型需要处理信息不完整的情况。通过引入自检清单机制和缺失信息处理流程,可以显著提升模型输出的准确性和可靠性。本文档介绍如何设计和使用这些技巧。 提示词功能流程 本提示词方案的核心功能流程如下: 用户提问 ↓ [场景识别] 简单场景与复杂场景自动区分 ↓ ├─→ 简单场景 → [直接回答...

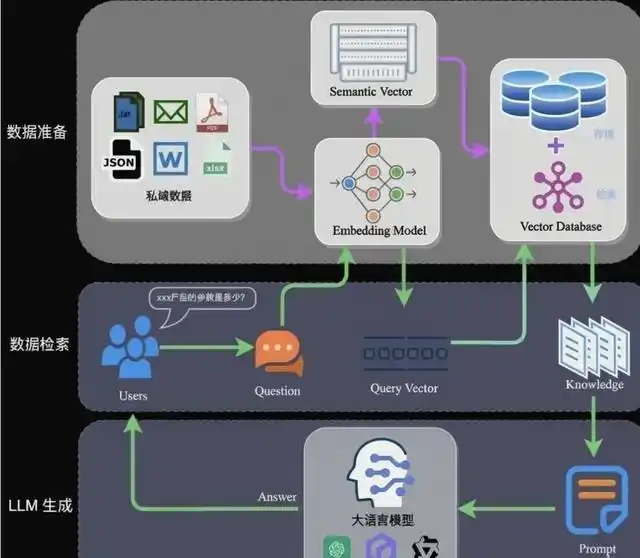

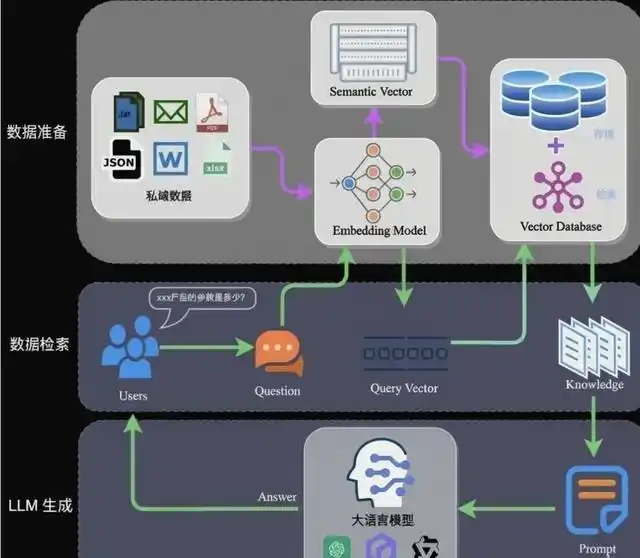

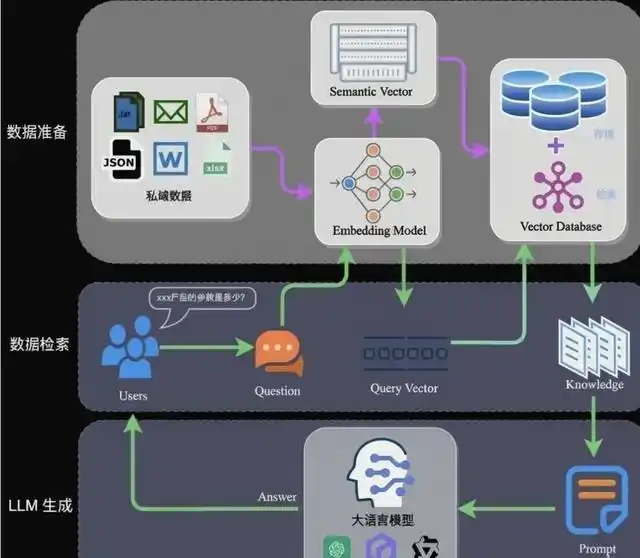

RAG知识库多跳查询方案 1. 方案解决的问题 在传统的RAG(检索增强生成)知识库问答场景中,当用户提问涉及文档附件内容时,存在以下问题: 附件内容检索不精准:附件文档通常包含多个章节,在知识库中作为单个文档存储时,检索容易带出无关章节内容,影响答案准确性 附件引用信息缺失:大模型回答中虽然可能提到”详见附件X”,但无法直接展示附件具体内容,用户体验不完整 多跳查询效率...

lightRAG知识图谱使用和工作流集成 lightRAG简介 LightRAG,知识图谱,简单且快速的检索增强生成(RAG)框架。 lightRAG部署 没有提供配置用的UI界面,所有配置都位于.env文件内。 docker部署 git clone https://github.com/HKUDS/LightRAG.git cd LightRAG cp env.example .en...

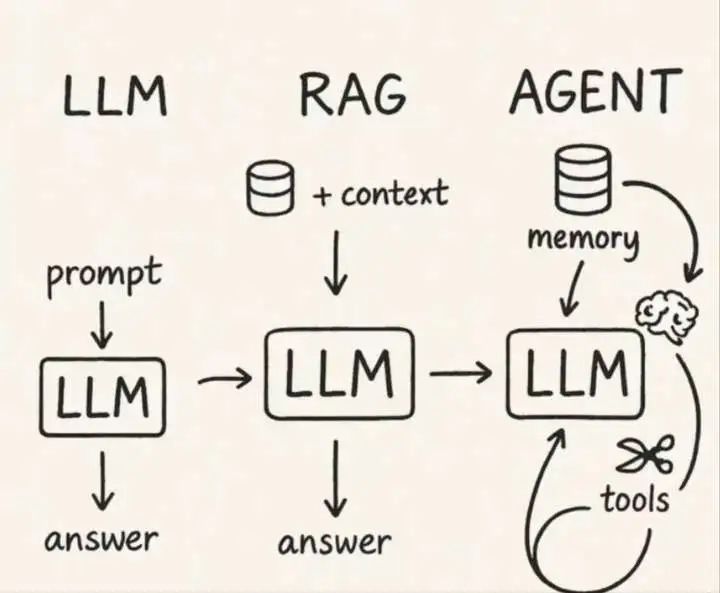

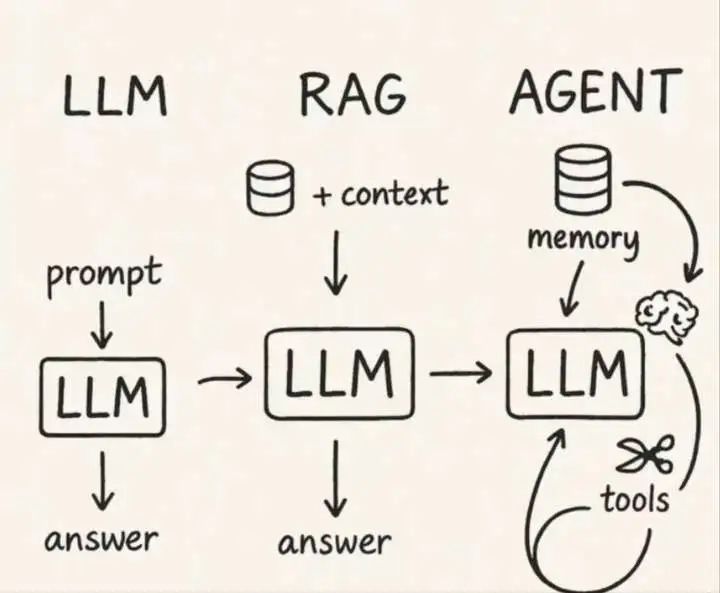

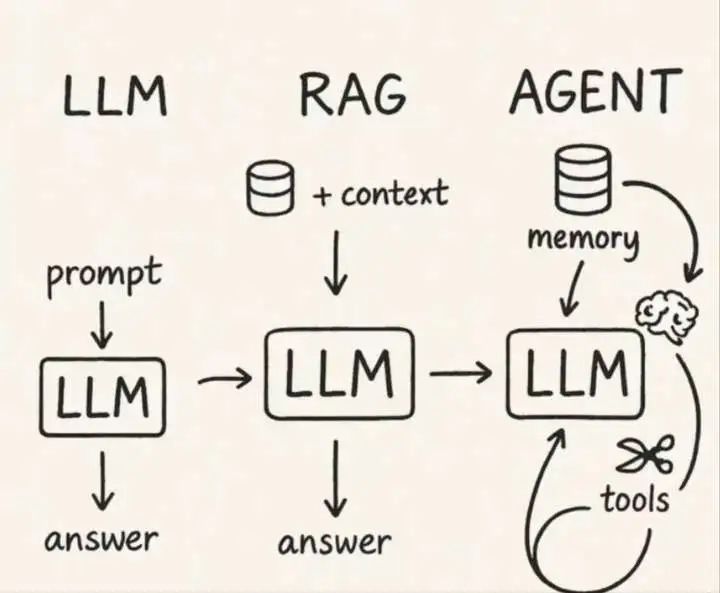

dify使用简介 简单介绍dify使用,根据官方的使用文档讲解,结合开源dsl工作流合集,使用云上dify环境演示。着重介绍dify工作流中图表生成、RAG知识库检索、MCP工具调用等场景的应用。 dify简介 Dify https://github.com/langgenius/dify 是一个开源的 LLM 应用开发平台。其直观的界面结合了 AI 工作流、RAG 管道、Agent、模...

机器学习可视化集成方案 开源的机器学习训练可视化平台 mlflow 腾讯音乐 cube-studio 较重,依赖很多组件。开源协议可能有限制 cube-studio wiki cube-studio 在线体验地址 mlflow+shapash可视化集成方案 mlflow使用 使用mlflow追踪模型训练并使用mlflo...

RAG知识图谱简介 一、什么是知识图谱 1.1 基本定义 知识图谱(Knowledge Graph) 是一种以图结构表示知识的方法,通过实体(Entity)- 关系(Relation)- 属性(Attribute) 三元组形式,将现实世界的对象及其关联关系进行结构化建模。 1.2 核心特征 结构化表达:以实体-关系-属性 (ERA) 结构化建模,而非纯文本段落 多跳关联:...

Ollama模型管理简介 1. Ollama 模型目录结构 默认存储位置 Linux/macOS: ~/.ollama/ └── models/ ├── manifests/ # 模型清单目录 │ └── registry.ollama.ai/ │ └── library/ │ └── [模型...

百度飞桨PaddleOCR图片印章检测技术简介 3.X和2.X区别较大,建议使用3.X版本。 PaddleX简介 PaddleX github地址 PaddleX模型产线使用概览 PaddleX安装文档 PaddleX高性能推理部署 PaddleX和PaddleOCR的区别 摘自官方文档PaddleX和PaddleOCR的关系。 PaddleOCR 与 Paddle...

华为昇腾LLM大模型部署和量化 相关平台 华为昇腾首页 魔乐社区-模型、工具、数据集下载 昇腾开发者社区 基础 MindIE镜像下载 MindIE容器启动 LLM部署 使用MindIE部署QwQ-32B 使用MindIE部署DeepSeek-R1 守护进程方式部署模型 通常模型服务化(暴露http接口等端点)部署配置文件位于...

MetaTrader 4交易策略工具简单使用 MT4简介 MetaTrader 4(简称 MT4) 是由 MetaQuotes Software 公司开发的一款全球广泛使用的电子交易平台,最初专为外汇(Forex)交易设计,如今已扩展支持多种金融资产的交易,包括:外汇(货币对)、贵金属(如黄金 XAU/USD、白银 XAG/USD)、差价合约(CFD)、股票指数,部分平台还支持能源(如原油...